El supercómputo, herramienta esencial en el ámbito científico

Enrique Ibarra-Laclette y Emanuel Villafán*

Los sistemas de supercómputo son equipos especializados en el procesamiento de datos masivos y se han constituído como una de las herramientas fundamentales para la investigación y el desarrollo tecnológico. Desde hace casi 10 años, el INECOL cuenta con un equipo de esta naturaleza, gracias al cual se han podido desarrollar múltiples proyectos encaminados a entender y conservar la diversidad biológica de nuestro país.

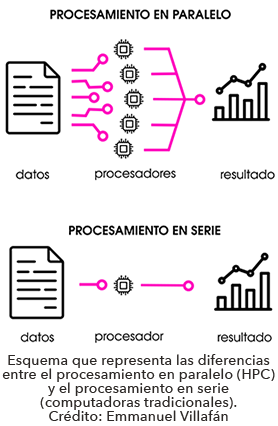

Los sistemas de supercómputo, también conocidos como sistemas de cómputo de alto rendimiento (HPC, del inglés High Performance Computing), son equipos especializados en el procesamiento de datos masivos (big data). A diferencia de las computadoras tradicionales, que realizan la mayoría de sus tareas una tras otra en un mismo procesador (procesamiento en serie), los sistemas HPC están diseñados para ejecutar una misma tarea en dos o más procesadores (procesamiento en paralelo). Gracias a esto, los HPC pueden analizar una gran cantidad de datos en una fracción del tiempo que se requeriría si se procesaran en serie.

Los sistemas de supercómputo, también conocidos como sistemas de cómputo de alto rendimiento (HPC, del inglés High Performance Computing), son equipos especializados en el procesamiento de datos masivos (big data). A diferencia de las computadoras tradicionales, que realizan la mayoría de sus tareas una tras otra en un mismo procesador (procesamiento en serie), los sistemas HPC están diseñados para ejecutar una misma tarea en dos o más procesadores (procesamiento en paralelo). Gracias a esto, los HPC pueden analizar una gran cantidad de datos en una fracción del tiempo que se requeriría si se procesaran en serie.

Por mencionar algunos de los ejemplos más comunes en los que se utilizan los HPC están el estudio de la dinámica de fluidos, el modelado para realizar el pronóstico del tiempo, las simulaciones sobre el comportamiento de los materiales y el análisis de datos geoespaciales. También, y sobre todo en las últimas décadas, los HPC se han convertido en una herramienta fundamental de la investigación académica y la innovación científica e industrial pues se utilizan para llevar a cabo la resolución de problemas complejos y de gran envergadura en tiempos relativamente cortos y considerando para dicho fin una gran cantidad de información que se analiza de manera simultánea y que muchas veces es almacenada en repositorios y bases de datos de acceso público. Quizá algunas de las aplicaciones más recientes de los HPC son las inteligencias artificiales, con estas se busca llevar a cabo la automatización del aprendizaje y el “razonamiento” para agilizar la toma de decisiones en función de una gran cantidad de información que se analiza.

Gracias al uso de algunas nuevas tecnologías y la inclusión de los HPC en el ámbito de la investigación científica (la bioinformática), hoy día se han elucidado los genomas de miles de especies, incluyendo microorganismos, plantas, hongos y animales. Esto está cambiando no sólo la forma en la que hacemos ciencia hoy en nuestros días, también está cambiando muchos de los paradigmas que rigen los estudios genómico-evolutivos, de la diversidad y de poblaciones e incluso el cómo estos podrían cambiar hacia el futuro en escenarios poco favorables como presume el cambio climático.

Gracias al uso de algunas nuevas tecnologías y la inclusión de los HPC en el ámbito de la investigación científica (la bioinformática), hoy día se han elucidado los genomas de miles de especies, incluyendo microorganismos, plantas, hongos y animales. Esto está cambiando no sólo la forma en la que hacemos ciencia hoy en nuestros días, también está cambiando muchos de los paradigmas que rigen los estudios genómico-evolutivos, de la diversidad y de poblaciones e incluso el cómo estos podrían cambiar hacia el futuro en escenarios poco favorables como presume el cambio climático.

En el Instituto de Ecología A.C. (INECOL) son muchos los proyectos de investigación que se desarrollan en dicho sentido. Si bien, algunos buscan elucidar los genomas completos tanto de especies vegetales de importancia agroforestal, como el de aquellos patógenos o plagas que las asedian, otros proyectos buscan entender a nivel molecular el cómo estas interacciones tienen lugar. A proyectos como los antes mencionados, y, entre muchos otros, se suma también el evaluar mediante modelos que se analizan computacionalmente, los riesgos que implica la invasión de especies exóticas y cómo estas podrían dispersarse en función de sus potenciales especies hospederas, el estudio de la integridad y la conservación de los ecosistemas, el estudio de las relaciones e interacciones entre las especies que pertenecen a una misma comunidad y el cómo estas se benefician.

En el Instituto de Ecología A.C. (INECOL) son muchos los proyectos de investigación que se desarrollan en dicho sentido. Si bien, algunos buscan elucidar los genomas completos tanto de especies vegetales de importancia agroforestal, como el de aquellos patógenos o plagas que las asedian, otros proyectos buscan entender a nivel molecular el cómo estas interacciones tienen lugar. A proyectos como los antes mencionados, y, entre muchos otros, se suma también el evaluar mediante modelos que se analizan computacionalmente, los riesgos que implica la invasión de especies exóticas y cómo estas podrían dispersarse en función de sus potenciales especies hospederas, el estudio de la integridad y la conservación de los ecosistemas, el estudio de las relaciones e interacciones entre las especies que pertenecen a una misma comunidad y el cómo estas se benefician.

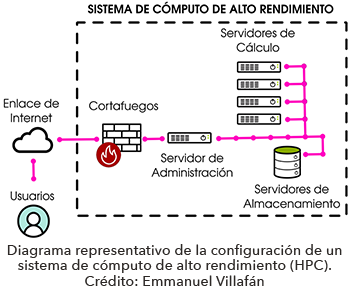

La realización de dichos proyectos no sería factible sin el uso de un HPC de características muy particulares en cuanto a su configuración, mismo que por su gran velocidad, fue en su momento nombrado Huitzilin (en náhuatl quiere decir colibrí). Desde su puesta en marcha (hace aproximadamente 10 años), Huitzilin ha sido un sistema que opera en óptimas condiciones gracias a proyectos propios de los investigadores financiados en su mayoría por el CONACyT. Cuenta actualmente con 10 nodos de cálculo (560 núcleos de procesamiento en total), cada uno con una memoria RAM que va de 750 Gb a 1 Tb. Además, tiene un sistema de almacenamiento de 140 Tb y cientos de aplicaciones especializadas que han sido instaladas para el análisis de datos biológicos. Gracias a esta infraestructura, se ha brindado servicio a más de 80 usuarios del INECOL y a muchos otros adscritos tanto a centros públicos de investigación del CONACyT, como adscritos a otras facultades, institutos, centros de investigación y algunas universidades que cuentan con programas afines de educación superior. A través de la impartición de cursos se ha capacitado a cientos de estudiantes en el uso de herramientas computacionales especializadas, se han formado decenas de profesionistas y especialistas en temas de ecología y biodiversidad, y se han generado resultados que han derivado en la publicación de múltiples artículos científicos y de divulgación.

La realización de dichos proyectos no sería factible sin el uso de un HPC de características muy particulares en cuanto a su configuración, mismo que por su gran velocidad, fue en su momento nombrado Huitzilin (en náhuatl quiere decir colibrí). Desde su puesta en marcha (hace aproximadamente 10 años), Huitzilin ha sido un sistema que opera en óptimas condiciones gracias a proyectos propios de los investigadores financiados en su mayoría por el CONACyT. Cuenta actualmente con 10 nodos de cálculo (560 núcleos de procesamiento en total), cada uno con una memoria RAM que va de 750 Gb a 1 Tb. Además, tiene un sistema de almacenamiento de 140 Tb y cientos de aplicaciones especializadas que han sido instaladas para el análisis de datos biológicos. Gracias a esta infraestructura, se ha brindado servicio a más de 80 usuarios del INECOL y a muchos otros adscritos tanto a centros públicos de investigación del CONACyT, como adscritos a otras facultades, institutos, centros de investigación y algunas universidades que cuentan con programas afines de educación superior. A través de la impartición de cursos se ha capacitado a cientos de estudiantes en el uso de herramientas computacionales especializadas, se han formado decenas de profesionistas y especialistas en temas de ecología y biodiversidad, y se han generado resultados que han derivado en la publicación de múltiples artículos científicos y de divulgación.

A pesar de todos estos logros, creemos que Huitzilin tiene aún mucho por ofrecer a la comunidad académica del INECOL y de la región. Por esta razón, el jueves 4 de mayo en punto de las 10:30 hrs se llevará a cabo el 1er Coloquio de Biología y Ecología Computacional en el INECOL. El objetivo de este evento es brindar a la comunidad de investigadores/as, tecnólogos/as y estudiantes del INECOL un espacio para reflexionar sobre las ventajas y potencialidades del uso de infraestructura de cómputo de alto rendimiento para el estudio de la biodiversidad. Esperamos que la nutrida participación de la comunidad en dicho coloquio fortalezca los lazos de colaboración y contribuya a un mayor entendimiento y protección de la riqueza biológica de México.

Pueden consultar el programa del evento en la página del INECOL y seguir su transmisión en vivo a través de su página de Facebook (inecolxalapa).

*Red de Estudios Moleculares Avanzados